Prolog:

Es war einmal ein Mädchen, dem wurde eindeutig eine rote Kappe zugeordnet, wodurch es als Rotkäppchen definiert wurde. „Kind“, argumentierte die Mutter, „werde kreativ, mathematisiere die kürzeste Verbindung zur Großmutter, analysiere aber nicht die Blumen am Wege, sondern formuliere deinen Weg in systematischer Ordnung.“

Friedrich Wille (* 5. Januar 1935; † 9. August 1992), deutscher Mathematiker und Professor an der Universität Kassel.

Die ethischen KI-Leitlinien der europäischen Union (EU)

Bereits im Oktober 2018 haben wir hier in unserem Blog mit dem Beitrag Compliance und Maschinenwesen (RPA) ausführlich über die neuen Möglichkeiten und Gefahren von Robotern und künstlicher Intelligenz (KI) berichtet.

Aus aktuellem Grund möchten wir diesen Beitrag ergänzen, da die europäische Union (EU) ein 52-köpfiges internationales Expertenteam beauftragt hat, zum ersten Mal ethische Leitlinien im Hinblick auf KI und Compliance zu erstellen. Am 8. April 2019 wurden nun diese Leitlinien durch die EU veröffentlicht. Zu den Grundinhalten dieser ethischen Leitlinien gehören:

- Vorrang menschlichen Handelns und menschlicher Aufsicht

- Robustheit und Sicherheit

- Privatsphäre und Datenqualitätsmanagement

- Transparenz

- Vielfalt, Nichtdiskriminierung und Fairness

- gesellschaftliches und ökologisches Wohlergehen

- Rechenschaftspflicht

Bevor wir nun hier in unserem Compliance Blog diese Leitlinien veröffentlichen, ein kurzer Einstieg in die Thematik. Ausführlich wird das Thema etwas weiter unten in unserem Blog-Beitrag beschrieben.

Künstliche Intelligenz (KI) – Ein alter Hut

Ist Künstliche Intelligenz eine innovative und neue Thematik unserer Zeit? Sicher nicht! Der Begriff selbst wurde bereits im Jahr 1955 erstmals von John McCarthy erwähnt und definiert. Für McCarthy bestand das Ziel von KI darin, „Maschinen zu entwickeln, die sich verhalten, als verfügten sie über Intelligenz.“ Einige Jahre später erfand der Wissenschaftler den legendären LISP-Computer, der Programme schrieb, die sich selbst verändern konnten. Bereits hier zeigt sich eine der grundlegenden und typischen Eigenschaften von KI-Algorithmen.

Die Programmiersprache LISP (englisch List Processing / deutsch Listen-Verarbeitung) gilt nach Fortran (IBM / 1953) als zweitälteste Programmiersprache der Welt, die bis heute noch verbreitet und genutzt wird.

Was bedeutet KI?

Die Künstliche Intelligenz (KI) bietet schon jetzt Unternehmen aus vielen Branchen extrem hohe Möglichkeiten und Chancen. Nimmt man als Ansatz die Wechselwirkung zwischen dem unternehmerischen Risiko und den gesetzten Zielen, sieht man schnell, welchen Beitrag Künstliche Intelligenz für Compliance, Governance and Risk Aktivitäten für das Unternehmen erzielen kann.

Laut einer aktuellen Studie aus dem Jahr 2019 sehen 500 Unternehmen in Deutschland den Einsatz von KI in den Segmenten:

- Datenanalyse für Entscheidungsprozesse (70%)

- Prozessautomatisierung bestehender Geschäftsprozesse (63%)

- Chatbots (47%)

- wesentlicher Bestandteil neuer digitaler Geschäftsmodelle (44%)

- Speech Processing (42%)

- Bestandteil von Produkten und Dienstleistungen (39%)

Betrachtet man nur die beiden erst genannten Einsatzmöglichkeiten von KI, welche für ein Unternehmen bereits jetzt oder in der nahen Zukunft an Wichtigkeit gewinnen werden, so erkennt man schnell, wie sehr sich die KI in das Aufgabenumfeld eines Compliance Officers integrieren wird. Kontrolliert momentan der Mensch noch die Daten für Entscheidungen oder ist ein Mensch maßgeblich in die laufenden Geschäfts- und Entscheidungsprozesse eingebunden und verantwortlich, so wird in der Zukunft die KI immer mehr in diese internen Abläufe eingreifen. Genau hier definieren sich neue Risiken im Unternehmen und neue Aufgabenbereiche der Compliance.

Neue Aufgabenbereiche und Risiken

Darüber hinaus verändert der Einsatz von KI und Robotern in der Produktion oder Chatbots im Unternehmen auch die Risikoszenarien. Der Arbeitsschutz und die Arbeitszeiten spielen bei einem KI-gestützten Roboter natürlich keine Rolle, auch die Frage der Korruption stellt sich bei einem KI-gestützten Algorithmus nicht. Der Umkehrschluss ist, dass sich demzufolge neue Fragen und Aufgabenbereiche zu Compliance, Governance and Risk Aktivitäten im Unternehmen der Zukunft stellen:

- Ist die Software oder der Roboter extern manipulierbar?

- Sind die Quellcodes nicht einsehbar und geschützt?

- Wie schützt man sich gegen Hackerangriffe?

- Sind die Veränderungen durch KI nachvollziehbar und transparent?

- Wie kommuniziert das Unternehmen den Einsatz von KI?

- Entspricht das gewünschte Ergebnis immer den rational optimierten Anwendungen von internen oder externen Ressourcen?

- Was macht die Compliance-Abteilung, wenn Software falsch programmiert ist, also das Ergebnis oder die Handlung (Output) nicht dem geplanten, gewollten oder gewünschten Ergebnis entspricht?

Momentan bestehen die Aufgaben eines Compliance Officers in der Kontrolle und Analyse menschlichen Handelns zur Vermeidung von Risiken oder in der Aufdeckung und Abwehr von Gefahren, die intern oder extern das Unternehmen bedrohen. Ein logischer und unabdingbarer Schritt, zum Beispiel mit der Ausbildung und Integration eines IT-Compliance Officers, wird es sein, diesen Gefahren und Risiken in der Zukunft entgegen zu treten. Gleiches gilt selbstverständlich auch bei der Entwicklung neuer Produkte oder Unternehmensschwerpunkte. Hier müssen bereits bei der frühen Planung neue Risiko-Szenarien, ausdrücklich auch im Bereich der Compliance, in Verbindung mit den Möglichkeiten durch KI, mit einfließen und signifikant beachtet werden.

Was genau ist aber nun KI eigentlich?

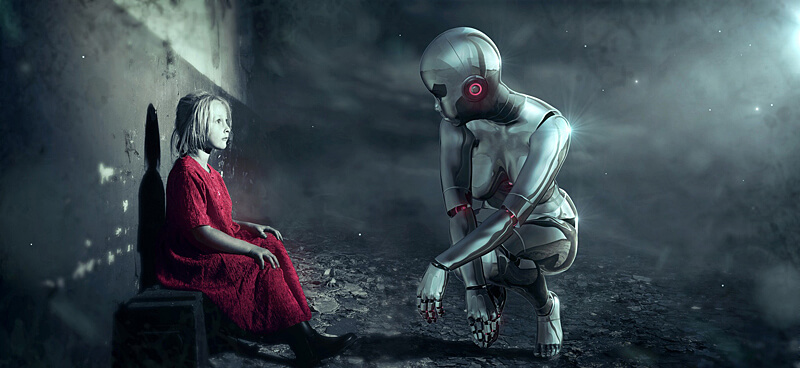

Der Begriff der Künstlichen Intelligenz wird definiert als die Wissenschaft und Entwicklung intelligenter Maschinen und Computerprogramme zur Umsetzung unternehmerischer Anforderungen und Ziele. Explizit geht es um die Entwicklung und Realisation eines Computergehirns, welches wie ein Mensch denkt und agiert bzw. um Maschinen und Roboter, die nicht nur Handlungen, sondern im weiteren auch Entscheidungen übernehmen werden.

Intelligenz: Ich lerne, Du lernst, Wir lernen

Es steht außer Frage: KI ist bereits jetzt, obwohl in vielen Branchen noch im Anfangsstadium, nicht nur einer der wichtigsten technologischen Fortschritte unserer Zeit, sondern wird unausweichlich wegweisend für einen Großteil der gesamten Geschäftswelt in den kommenden Jahren sein. Ob nun im geschäftlichen oder privaten Bereich, wird man sich dieser Technologie nicht entziehen können.

Alles dies setzt eines zwingend voraus: Intelligenz.

Der Begriff Intelligenz leitet sich vom dem lateinischen Wort »intellegere« ab, was so viel wie »verstehen, erkennen, einsehen« bedeutet und damit bereits anhand dieser Übersetzung auf eine schnelle Auffassungsgabe in gleichermaßen vertrauten und ungewohnten Situationen verweist. Vereinfachend wird Intelligenz definiert als die Fähigkeit des Geistes, Zusammenhänge zu erkennen und Probleme zu lösen. Doch eine einzige, allgemeingültige Definition gibt es nicht.

Nach dem heute gängigen Drei-Schichten-Modell aus dem Jahr 1993 von John Bissell „Jack“ Carroll, einem US-amerikanischen pädagogischen Psychologen, Psycholinguisten und Intelligenzforscher, dürfen wir uns die menschliche Intelligenz wie ein Unternehmen im Gehirn vorstellen, in der es einen Vorstand (Generalfaktor), mehrere Abteilungen (Sekundärfaktoren) und bis zu 70 Arbeitsgruppen (Einzelfaktoren) gibt. Mit der Künstlichen Intelligenz setzt sich dieses Drei Schichten Modell fort, natürlich mit anderen – aber doch dem der menschlichen Intelligenz zumindest vergleichbaren – Faktoren.

Die Evolution der Künstlichen Intelligenz ist vergleichbar zu einem Schirm. Maschinelles Lernen und Deep Learning sind beide unter dem Schirm der Künstlichen Intelligenz angesiedelt und zwar genau in dieser Reihenfolge. Ohne Künstliche Intelligenz gäbe es kein Maschinelles Lernen. Und Deep Learning hat seinen Ursprung im Maschinellen Lernen. Trotzdem wäre es durchaus logisch, den Schirm einfach umzudrehen. Denn für Deep Learning sind nach oben keine Grenzen gesetzt.

Der Unterschied zwischen den drei Arten von Künstlicher Intelligenz und Lernen lässt sich einfach verstehen, wenn man diese mit vertrauten Prozessen des Trainings und der Ausbildung vergleicht.

- Künstliche Intelligenz ähnelt dem Vorgang, einem Auszubildenden genau die Information zu vermitteln, die er lernen soll.

- Maschinelle Intelligenz / Maschinelles Lernen ist vergleichbar mit einem Auszubildenden, dem man ein Buch in die Hand drückt, sodass er sich den Lernstoff selbst erarbeitet.

- Deep Learning entspricht dem des Maschinellen Lernens. Der Unterschied ist aber, dass der Auszubildende in der Lage ist, aus seinen Fehlern zu lernen und sich kontinuierlich zu verbessern.

Im Fall von Künstlicher Intelligenz, Maschinellem Lernen und Deep Learning sind die Auszubildenden Maschinen und die Lehrbücher Daten. Bei der Künstlichen Intelligenz wird die Maschine mit einem endlosen Strom an Daten gefüttert. Beim Maschinellen Lernen und bei Deep Learning hingegen nutzt die Maschine externe Quellen wie das Internet oder Sensoren.

Stellt man die menschliche Intelligenz der Künstlichen Intelligenz gegenüber, wird ein grundlegender Aspekt schnell deutlich: War es schon immer fast unmöglich, menschliche Intelligenz klar und eindeutig zu definieren, so wird es spannend sein, ob dies jemals auch mit Künstlicher Intelligenz möglich sein wird. Fragt man heute 10 Forscher nach einer klaren Definition der menschlichen Intelligenz so erhält man im Zweifelsfall 10 unterschiedliche Definitionen. Wie will man dann, jetzt oder in 10 Jahren, Künstliche Intelligenz eindeutig definieren und wird es erforderlich sein, dann wieder neue (oder alt hergebrachte) Definitionen der menschlichen Intelligenz zu erforschen oder zu überdenken?

Die praxisbezogene Anwendung und der Einsatz von Künstlicher Intelligenz ist nun schon lange nicht mehr ein theoretischer Ausblick in die Zukunft, sondern wird bereits heute in der täglichen und praxisorientierten unternehmerischen Umgebung eingesetzt. Bereits jetzt können Softwarelösungen und Roboter lernen, selbst Aufgaben auszuführen und Entscheidungen zu treffen. Bestes Beispiel sind hier Applikationen, die bereits heute Entscheidungen im Bank- und Versicherungswesen treffen.

Ali Baba und die 40 Roboter

Bevor wir nun nachfolgend hier in diesem Beitrag die von der EU verabschiedeten ethischen Compliance-Richtlinien veröffentlichen, ein Praxisbeispiel, in welcher Richtung bzw. in welchem Umfeld und Kontext diese Leitlinien in der Zukunft Anwendung finden könnten.

Alibaba, in Europa vor allem als großer chinesischer E-Commerce-Anbieter bekannt, erhofft sich dank seiner eigenen und internen KI-Forschung und der Entwicklung eigener KI-Chips mehr Innovationen für sein Kerngeschäft. Was aber machen diese KI-Chips von Alibaba genau? Nun, schon hier beginnt eine mögliche (auch ethische) Gefahr und ein nicht abzuschätzendes Risiko, denn dies weiß nur und einzig das Unternehmen Alibaba selbst. Auch im Hinblick auf ethische Grenzen und mögliche Verletzungen gibt es hier keinerlei Hinweise oder Regelungen.

Eine installierte und bereits im normalen Geschäftsbetrieb laufende KI-Anwendung bei Alibaba vereinfacht die Arbeit der nationalen und internationalen Online-Händler auf der Plattform, indem es Texte und Inhalte von der KI allein und ohne menschliche Hilfe schreiben lässt. Die KI-Software kann pro Sekunde (!) 20.000 Zeilen Content produzieren. Händler können damit ihre Produktinformationen automatisch durch die KI generieren lassen, ohne dass ein Mensch diese Zeit investieren muss. Das Programm hat Millionen bereits vorhandener Inhalte auf den verschiedenen Alibaba-Plattformen analysiert und benutzt Deep-Learning-Modelle und Technologien zur Verarbeitung natürlicher Sprache, um Content zu produzieren.

Für die Nutzung des KI-Tools müssen Händler lediglich einen Link zu einer beliebigen Produktseite eingeben und können dann aus mehreren Beispielen die passende Vorlage auswählen. Alles weitere erstellt und geniert die KI selbst. Die Erstellung des Textes ist aber nur der erste Schritt der KI. Die Händler auf der Plattform können zum Beispiel auswählen, ob der Text ihrer Produktbeschreibung werblich, poetisch oder witzig klingen soll. Bereits heute nutzen nationale und internationale Unternehmen jedweder Branche und Größe auf den verschiedenen Alibaba-Handelsplattformen täglich das Tool und die KI im Schnitt fast eine Million Mal.

Alibaba bestätigt selbst, dass hierfür bereits bestehende Chips und Algorithmen aus externen Quellen genutzt werden und diese mit internen KI-Entwicklungen modifiziert werden. Einzig, das Ergebnis aus diesen Mutationen und die künstliche Weiterentwicklung wird wohl ein internes Geheimnis bleiben. Ob hier neben praxis- oder marketingorientierten Regelungen, auch ethische Grundsätze eine Rolle spielen, wird man wohl kaum erfahren.

Die Ethische Leitlinie der EU für KI und Compliance

Hier setzt die Überlegung der EU ein und es wurden durch eine internationale Kommission Ethische Leitlinien im Hinblick auf KI und Compliance entwickelt, die am 8. April 2019 veröffentlicht wurden.

In dieser Leitlinie verankert sind sieben Anforderungen, die nicht nur Vertrauen, sondern auch einen Kontrollmechanismus in und für KI schaffen sollen. Sie betreffen Anforderungen und Fragen nach der Kontrolle, der Sicherheit, dem Datenschutz, der Nichtdiskriminierung, der Nachhaltigkeit, der Verantwortlichkeit und der Transparenz der von KI genutzten Algorithmen.

Inhalte:

- Vorrang menschlichen Handelns und menschlicher Aufsicht: KI-Systeme sollten gerechten Gesellschaften dienen, indem sie das menschliche Handeln und die Wahrung der Grundrechte unterstützen; keinesfalls aber sollten sie die Autonomie der Menschen verringern, beschränken oder fehlleiten.

- Robustheit und Sicherheit: Eine vertrauenswürdige KI setzt Algorithmen voraus, die sicher, verlässlich und robust genug sind, um Fehler oder Unstimmigkeiten in allen Phasen des Lebenszyklus des KI-Systems zu bewältigen.

- Privatsphäre und Datenqualitätsmanagement: Die Bürgerinnen und Bürger sollten die volle Kontrolle über ihre eigenen Daten behalten und die sie betreffenden Daten sollten nicht dazu verwendet werden, sie zu schädigen oder zu diskriminieren.

- Transparenz: Die Rückverfolgbarkeit der KI-Systeme muss sichergestellt werden.

- Vielfalt, Nichtdiskriminierung und Fairness: KI-Systeme sollten dem gesamten Spektrum menschlicher Fähigkeiten, Fertigkeiten und Anforderungen Rechnung tragen und die Barrierefreiheit gewährleisten.

- Gesellschaftliches und ökologisches Wohlergehen: KI-Systeme sollten eingesetzt werden, um einen positiven sozialen Wandel sowie die Nachhaltigkeit und ökologische Verantwortlichkeit zu fördern.

- Rechenschaftspflicht: Es sollten Mechanismen geschaffen werden, die die Verantwortlichkeit und Rechenschaftspflicht für KI-Systeme und deren Ergebnisse gewährleisten.

Nach der Verabschiedung dieser Richtlinien wird die EU-Kommission nun zu einem kurzfristigen Termin im Sommer 2019 eine Testphase beginnen. Ab sofort ist es für Unternehmen aller Branchen und Größen, öffentliche Einrichtungen, Verwaltungen und Organisationen möglich, der Europäischen KI-Allianz beizutreten Die Mitglieder der hochrangigen, von der EU beauftragten, Expertengruppe werden unterstützend tätig sein, die Leitlinien sowohl teilnehmenden Unternehmen als auch den relevanten Interessengruppen in den einzelnen Ländern vorzustellen und zu erläutern.

Ein wichtiges Ziel der EU-Kommission ist es, diesen Ansatz der KI-Ethik so schnell als möglich auf die internationale und globale Ebene zu bringen. Aus diesem Grund wird die Expertengruppe der EU die Zusammenarbeit mit Ländern wie Japan, Kanada oder Singapur verstärken und weiterhin eine aktive Rolle bei internationalen Diskussionen und Initiativen spielen. Parallel werden natürlich auch Unternehmen aus anderen Ländern und internationale Organisationen einbezogen.

Unternehmerische Risiken durch KI

Hintergrund der ethischen Regeln für KI im Compliancebereich der EU sind natürlich unternehmerische Risiken, welche sich durch den Einsatz und die Nutzung von KI im Unternehmen ergeben können. Nachfolgend einige grundlegende Risikofaktoren, die sich nicht nur durch die schon mögliche Nutzung von KI, sondern auch den zukünftigen Einsatz von immer mehr KI ergeben können:

Unterlegenheit des Menschen:

Ein mögliches Risiko, das gleichermaßen viele Menschen und Unternehmen fürchten, ist die Entwicklung einer „Superintelligenz“. Unter einer Superintelligenz versteht man eine Technologie, die sich selbst optimiert und dadurch vom Menschen unabhängig wird. Die Beziehung zwischen den Menschen und dieser superintelligenten Technik könnten problematisch werden – am Ende könnte der Mensch der Technik gar unterliegen. Eine vorsätzlich bösartige KI halten Forscher allerdings für nahezu ausgeschlossen. Ein tatsächliches Risiko sehen viele dagegen in einer künstlichen Intelligenz, die so kompetent ist, dass sich ihre Aktivitäten verselbstständigen – Aktivitäten, die dann für den Menschen schädlich werden könnten.

Abhängigkeit von der Technik:

Viele sehen die Risiken der KI nicht in einer generellen Unterlegenheit, sondern in einer wachsenden Abhängigkeit des Menschen von technologischen Systemen. In der medizinischen Versorgung etwa, wo der Einsatz von Pflegerobotern bereits getestet wird, macht sich der Mensch zunehmend zum überwachten Objekt technischer Systeme. Dabei laufe er Gefahr, ein Stück seiner Privatheit und Selbstbestimmung aufzugeben. Nicht nur für die Medizin werden diese Bedenken geäußert, sondern auch in Bezug auf KI-gestützte Anwendungen im Bank- und Versicherungswesen, bei der Videoüberwachung oder intelligente Algorithmen im Netz.

Datenschutz und Machtverteilung:

Intelligente Algorithmen können die wachsenden Datensätze immer effizienter verarbeiten. Vor allem für den Internethandel ist dies zunächst eine positive Nachricht. Doch die Weiterverarbeitung von Daten durch KI-Technologien wird für Verbraucher immer schwerer nachzuvollziehen und zu überwachen. Stattdessen haben Unternehmen und Experten mit dem entsprechenden technischen Know-how die alleinige Kontrolle.

Beeinflussung von Meinungsbildung:

Als weiteres Risiko könnten KI-Technologien öffentliche Meinungen auch gezielt lenken. Anlass für diese Bedenken bieten Technologien, die ihre Nutzer bis ins Detail kennen, oder der Einsatz von Social Bots, die die öffentliche Haltung beeinflussen. Bei wachsender Intelligenz dieser Techniken wird das Risiko einer Meinungsbeeinflussung immer höher. Dies wiederrum kann sich im Hinblick auf Rufschädigung oder Instrumentarien aus dem Bereich Marketing katastrophal auf ein Unternehmen auswirken, welches zum Beispiel von massiven „Fake-News“ angegriffen wird.

Arbeitsmarkt:

Die diskutierten Risiken von KI auf dem Arbeitsmarkt betreffen vor allem den Abbau von Arbeitsplätzen. Skeptiker befürchten, dass KI-Technik den Menschen zunehmend überflüssig machen könnte, ob nun durch den Putzroboter, den Pflegeroboter oder durch selbstnavigierende Transportsysteme. In der Medizinethik wird derzeit der Einsatz von Pflegerobotern kontrovers diskutiert. Die Befürchtung: Die Versorgung von pflegebedürftigen Menschen durch Roboter führt zu einer sozialen Kälte. Gleiches gilt für den Einsatz von KI gestützter Software, zum Beispiel im Bank-, Rechnungs- oder Versicherungswesen.

Diskriminierende Algorithmen:

Künstliche Technik liefert im Vergleich zum Menschen oft neutralere Ergebnisse – einer der vielen Vorteile künstlicher Intelligenz. Doch immer wieder zeigt KI-Technik auch Voreingenommenheit gegenüber Geschlecht oder Herkunft von Personen: Microsofts Chatbot Tay etwa imitierte innerhalb kürzester Zeit rassistische Sprache, Sicherheitstechnologien stufen „black neighbourhoods“ eher als Problembezirke ein und Werbeplattformen schalten bei männlichen Usern höher bezahlte Jobangebote. Das Problem ist schon länger bekannt und das British Standards Institute hat daher ethische Guidelines für Roboter herausgegeben. Doch lassen sich diese technisch nur schwer umsetzen – schließlich lernt die KI selbstständig aus ihrer Umwelt anhand von Lernprozessen, die von einzelnen Menschen nur begrenzt beeinflusst werden können.

Ausblick IT-Compliance Officer

Genau hier liegt eines der großen Hauptprobleme von und mit Künstlicher Intelligenz. Die Maschine lernt bereits heute in großen Teilen von und für sich selbst. Inwieweit der Mensch hier als Lehrer fungiert, ist bereits heute nicht mehr klar und eindeutig zu definieren.

All diese Risiken, die auf ein Unternehmen gleich welcher Größe und Branche zukommen werden, sind nicht nur eine Frage der Technik, der Hardware, der Software oder der Ethik. Gerade die Compliance im Unternehmen, die Umsetzung von Compliance-Regeln und die eventuelle Anpassung oder Aktualisierung des momentan verabschiedeten Compliance Management Systems (CMS) müssen auf der internen Agenda der Wichtigkeit für das Unternehmen auf höchster Priorität stehen.

Eine Herausforderung für jeden bereits tätigen oder zukünftigen Compliance Officer oder Chief Compliance Officer im Unternehmen und gleichermaßen die interne Beurteilung der Notwendigkeit, zum Beispiel durch die zusätzliche Position und Integration eines IT-Compliance Officers im Unternehmen, diesen Gefahren nachhaltig entgegenzutreten und sich vor diesen neuen Risiken zu schützen.

Epilog:

„Die größte Gefahr von künstlicher Intelligenz ist, dass die Menschen viel zu früh denken, dass sie KI verstanden haben.“

Eliezer Shlomo Yudkowsky (* 11. September 1979), amerikanischer Forscher und Autor. Er beschäftigt sich mit Entscheidungstheorie und den langfristigen sozialen und philosophischen Folgen der Entwicklung von Künstlicher Intelligenz.

Quellenangaben:

Ethikleitlinien für KI / Europäische Union, Brüssel / 2019

High-Level Expert Group on Artificial Intelligence / European Commission, Brüssel / 2019

Studie: Künstliche Intelligenz in Unternehmen / PWC PricewaterhouseCoopers GmbH / 2019

Alibaba: KI fügt für die Händler Produktinformationen ein / Onlinehändler-News / 2018

Künstliche Intelligenz: Anwendungen, Projekte, Trends / Industry of Things / 2018

Faszination KI: Was ist künstliche Intelligenz? / Digital Guide IONOS / 2018

Der Unterschied zwischen Künstlicher Intelligenz, Maschinelles Learning und Deep Learning / Coresystems / 2018